(BFM Bourse) - La jeune pousse chinoise a créé une onde de choc sur la tech en début de semaine, avec ses modèles de langage qui rivalisent avec ceux des grands groupes américains et qui ont été construits, a priori, avec des coûts bien moindres. Mais cela ne remet pas forcément en cause les investissements dans l'IA, ni même la demande pour les processeurs graphiques.

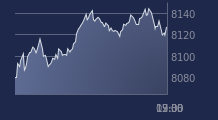

Un séisme a bousculé la tech en début de semaine. Les prouesses de la start-up chinoise Deepseek ont provoqué des craintes qui ont amené le Nasdaq Composite à baisser d'environ 3% lundi, tandis que les fabricants de puces Nvidia et Broadcom ont chuté de respectivement 16,97% et 17,4%.

Pour rappel, une série d'articles dans des médias réputés ont mis en valeur, le week-end dernier, les faits d'armes de Deepseek. La société chinoise a bâti des assistants d'intelligence artificielle (IA) - ou plus exactement des modèles de langage à grande échelle (LLM) - dont les performances rivalisent avec celles des modèles des grands groupes américains, comme le célèbre ChatGPT d'Open AI. Ce avec des coûts qui seraient, a priori, bien moindres.

>> Accédez à nos analyses graphiques exclusives, et entrez dans la confidence du Portefeuille Trading

Des dépenses remises en question

Comme le souligne Deutsche Bank, Deepseek aurait réussi à "entraîner", et donc construire son modèle de langage pour un coût de seulement 5,6 millions de dollars. En comparaison, le coût d'entraînement de GPT-4 d'Open AI se chiffrerait jusqu'à 100 millions de dollars, selon des estimations citées par la banque allemande.

De plus, Deepseek explique avoir entraîné son modèle open-source avec 2048 processeurs graphiques (GPU) H800 de Nvidia. Or ces puces sont moins puissantes que les GPU plus avancés de la société américaine, les H100. Ces puces respectaient les restrictions en termes de puissance imposées par l'administration américaine sur les exportations de semi-conducteurs vers la Chine, jusqu'à la fin 2023. Elles sont ensuite tombées sous le coup de nouvelles restrictions américaines.

Tout ceci a jeté à la fois une ombre tant sur la demande pour les processeurs graphiques les plus hauts de gamme que sur les lourdes dépenses à coup de dizaines de milliards de dollars que projettent les grands groupes de tech dans l'IA.

"La crainte que le nouveau modèle de la startup chinoise Deepseek, spécialisée dans l'IA, ne perturbe le modèle commercial actuel de l'IA a fait chuter les actions de Nvidia et d'ASML (un acteur néerlandais de l'industrie des semi-conducteurs", souligne ainsi Alex Stauffacher, de Vontobel.

"Le modèle R1 de Deepseek, mis en ligne le 20 janvier, affiche des performances similaires à celles des grands modèles de langage américains (LLM), mais sensiblement moins cher. Cela a suscité des inquiétudes quant à la nécessité de disposer de puces haut de gamme et d’une grande puissance de calcul", poursuit-il.

"La question de la capacité des grands groupes technologiques à rentabiliser les gigantesques investissements semble soudain se poser aux marchés", notait de son côté Alexandre Baradez, chef de l'analyse de marché chez IG France, lundi.

Des doutes sur Deepseek

Maintenant que la poussière est retombée, Deepseek incarne-t-il vraiment un "game changer" pour l'IA et donc pour les investisseurs? Si l'émergence de la société chinoise doit être prise avec sérieux, les inquiétudes du marché méritent d'être nuancées.

Tout d'abord, des doutes entourent les annonces de Deepseek. Le directeur général de Scale AI, Alexandr Wang, a affirmé sur CNBC, sans toutefois apporter de preuves concrètes, que Deepseek s'était procuré 50.000 puces Nvidia H100, et aurait ainsi contourné les restrictions américaines. Ce qui signifierait en creux que la société a bien besoin de ces modèles de puces plus avancés.

Dan Ives, une analyste de Wedbush connu pour être très optimiste sur la tech américaine en Bourse, se montre, lui, sceptique sur les déclarations de Deepseek.

"La panique qui s'est emparée des investisseurs ces derniers jours à propos du modèle Deepseek est moins liée au modèle qu'ils ont construit qu'à la manière dont ils l'ont construit..... 'Deepseek a construit ce modèle LLM avec 6 millions de dollars et aucun GPU moderne de Nvidia', alors pourquoi Microsoft dépense-t-elle 80 milliards de dollars et Meta 65 milliards de dollars en capex (dépenses d'investissements, NDLR) ?"' s'interroge-t-il.

"L'affirmation selon laquelle ce modèle a été construit pour 6 millions de dollars sans matériel Nvidia de nouvelle génération relève probablement de la fiction", assène-t-il.

"Nous ne savons pas si des puces H100 achetées en amont des restrictions ont été utilisées, ou si l'entreprise a loué des capacités de calcul de puces plus haut de gamme auprès de centres de données en Asie du Sud-Est", abonde Alex Stauffacher, de Vontobel.

Par ailleurs, le Financial Times a rapporté qu'OpenAI aurait des preuves établissant que Deepseek s'était appuyé sur les modèles d'algorithmes de la société américaine pour automatiser l'entraînement de son propre modèle open-source à moindre frais.

Entraînement et "inférence"

Au-delà de la construction des modèles de Deepseek, il n'est pas certain que ses avancées tonitruantes remettent en cause les investissements massifs dans l'intelligence artificielle.

Yann LeCun, un célèbre chercheur en intelligence artificielle, également chef de la recherche scientifique chez Meta, a écrit sur le réseau social Threads que la réaction du marché à Deepseek était "tristement injustifiée".

"Malentendu majeur sur les investissements dans l'infrastructure de l'IA: une grande partie de ces milliards est consacrée à l'infrastructure pour 'l'inférence', et non pour le training (entraînement, NDLR)", a-t-il ajouté.

Il convient ici de distinguer la phase d'entraînement d'un modèle de langage d'IA de "l'inférence" pour comprendre son propos.

L'entraînement est la phase "où le modèle apprend à répondre", explique un data scientist à BFM Bourse. Cette phase d'apprentissage passe par des calculs effectués à partir de milliards de paramètres. Cela revient en quelque sorte à "construire" le modèle.

L'inférence, elle, correspond à la phase d'utilisation du modèle. Ce dernier a déjà été entraîné et il va ensuite apporter des réponses ("prédictions") à des requêtes. "L’inférence de l’intelligence artificielle (IA) est la capacité des modèles IA entraînés à reconnaître des schémas et à tirer des conclusions à partir d’informations qu’ils n’ont jamais vues auparavant", explique IBM.

Après l'entraînement, le modèle est "figé", explique le data scientist précédemment cité. Durant la "phase" d'inférence, le modèle va, à chaque requête, refaire des calculs pour donner des réponses. C'est la multiplication de ces requêtes qui nécessite une grande puissance de calcul.

En clair, les milliards de dollars d'investissements dans l'IA voulus par les sociétés américaines ne visent donc pas tant à construire des modèles qu'à les opérer à une grande échelle.

"L'exploitation de services d'assistance à l'IA pour des milliards de personnes nécessite beaucoup de calculs. Une fois que les systèmes d'IA seront dotés de capacités de compréhension vidéo, de raisonnement, de mémoire à grande échelle et d'autres capacités, les coûts d'inférence augmenteront", a encore expliqué Yann LeCun sur Threads.

Besoin de puces

Deepseek aura, in fine, peut-être besoin d'investir davantage et de mettre la main sur des processeurs graphiques de dernière génération.

"La Chine a toujours su sauter certaines étapes et recréer une technologie existante à moindre coût, grâce à son ADN d’efficacité. Deepseek a néanmoins reconnu que son principal obstacle reste l’accès aux puces avancées d’IA/GPU (processeur graphique)", explique Yan Taw Boon, gérant chez Neuberger Berman, basé à Hong Kong et spécialiste des semi-conducteurs.

"La Chine accuse toujours 4 à 5 ans de retard sur le monde occidental en matière de semi-conducteurs de pointe. Sans ces puces, Deepseek admet qu'il leur est impossible de faire évoluer leur modèle pour un déploiement à grande échelle", ajoute-t-il.

Toutefois, avec l'émergence de la start-up chinoise, les investisseurs devraient scruter davantage les investissements dans l'intelligence artificielle. "La course à l'IA se poursuivra avec une prise en compte croissante du rapport coût-efficacité", pronostique Alex Stauffacher, de Vontobel.

Mais là encore, réduire les coûts et l'efficacité de l'intelligence artificielle ne signifie pas que la demande pour ces technologies, comme pour les processeurs graphiques chutera.

"Compte tenu du surplus de vigilance quant à la durabilité des gros investissements dans les infrastructures IA, nous nous attendons à un premier choc sur les valeurs hardware (le matériel, NDLR), ce qui est, pour nous, une opportunité d'achat, car l'amélioration du rapport coût-efficacité devrait à terme favoriser un élargissement des applications de l'IA et profiter à une chaîne d'approvisionnement technologique plus large", poursuit Alex Stauffacher.

Plus d'efficacité sur les coûts "ne se traduit pas nécessairement par une réduction de la demande de puces", abondent les analystes de Schroders. Ces derniers citent "le paradoxe de Jevon". Selon ce concept économique, une amélioration de l'efficacité des ressources entraîne souvent une plus grande consommation de ces ressources. "Dans ce contexte, une plus grande efficacité de calcul pourrait stimuler l'adoption et l'expansion de l'IA, compensant potentiellement toute réduction directe de la demande de puces", expliquent les analystes de Schroders.

Le directeur général d'ASML, Christophe Fouquet, a d'ailleurs déclaré cette semaine à CNBC qu'il s'attendait à ce que l'arrivée de nouveaux acteurs tels que Deepseek entraîne une hausse de la demande de semi-conducteurs, et non une baisse.

"Une baisse du coût de l'IA pourrait se traduire par un plus grand nombre d'applications. Plus d'applications signifie plus de demande au fil du temps. Nous considérons cela comme une opportunité d'augmenter la demande de puces", a-t-il expliqué.

Meta et Microsoft tentent de rassurer

Satya Nadella, le directeur général de Microsoft, a tenu un discours assez similaire. Questionné mercredi par les analystes sur l'impact de Deepseek, le dirigeant a jugé l'IA était confrontée aux phénomènes habituels qui s'observe dans l'informatique. Comme la fameuse loi de Moore, selon laquelle le nombre de transistors double tous les ans.

In fine, les coûts de l'IA baisseront et rendront ces technologies plus abordables pour les particuliers, avec davantage d'applications, a-t-il expliqué. "Ce type d'optimisations signifie que l'IA sera beaucoup plus omniprésente. Par conséquent, pour un hyperscaler comme le nôtre, un fournisseur de plateforme PC comme le nôtre, c'est une bonne nouvelle en ce qui me concerne", a conclu Satya Nadella.

Mark Zuckerberg, le directeur général de Meta, a lui tempéré l'impact que pourrait avoir Deepseek sur les dépenses d'investissements dans l'IA, jugeant qu'il était trop tôt pour tirer des conclusions. Pour l'heure, le dirigeant estime toujours qu'investir massivement dans les infrastructures "constituera un avantage stratégique au fil du temps", a-t-il ajouté.

Pour Oddo BHF, il est "difficile de se dire" que les "hyperscalers", c'est-à-dire les grands acteurs de l'informatique dématérialisée comme Alphabet, Amazon Web Services, ou Microsoft, réduiront significativement leurs dépenses d'investissement à court et moyen terme. Ce malgré l'émergence de Deepseek.

"La raison justifiant ce type d’investissement est beaucoup plus fondamentale pour ces sociétés: en reprenant les mots du CEO (directeur général) de Google 'le risque de sous-investir est bien plus grand que celui de surinvestir', l’IA étant clé pour la survie du business model des hyperscalers à long terme (que cela concerne l’utilisation de leurs services cloud, la publicité ou l’intégration de fonctionnalités IA pour le hardware)", développe le courtier.

"Nous avons discuté avec de nombreuses entreprises qui s'orientent vers l'IA et les cas d'utilisation, et Deepseek ne les fait en aucun cas hésiter à dépenser sept à huit chiffres de leur budget informatique au cours de l'année prochaine pour des initiatives d'IA", assure de son côté Dan Ives de Wedbush.

"En résumé, Deepseek a créé un modèle LLM génial (et le mérite en revient à ses développeurs de logiciels), mais ce modèle chinois de petit laboratoire d'IA/LLM n'entraîne pas dans sa chute l'ensemble de l'écosystème technologique américain. Tout comme Temu était le 'destructeur du modèle Amazon' il y a quelques années... l'équipe d'Amazon s'est adaptée et aujourd'hui, regardez où Temu et Amazon sont assis", conclut l'analyste.